Im ersten Teil dieser Artikelreihe über Risikosimulation habe ich ganz allgemein dargestellt, dass mit einer toolgestützten Szenarioanalyse die Auswirkungen von Schwankungen der Werttreiber einer Planung simuliert werden können. In der Praxis sind solche Kalkulationen meist daran gescheitert, dass der Aufwand für solche Simulationen sehr hoch war.

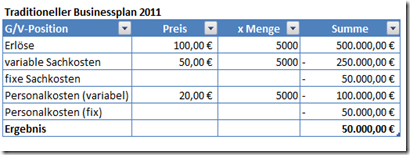

Mittlerweile erlauben verfügbare Softwaretools eine etwa bestehende Planung systematisch um Simulationen zu erweitern. Dies soll nun bewusst an einem einfachen Beispiel demonstriert werden. Mir liegt also ein „traditioneller“ in Excel modellierter Businessplan vor für ein Unternehmen, das seine Produkte in den Dollarraum exportiert.

Dieser Plan basiert auf folgenden Annahmen

Wir haben hier fünf Werttreiber mit jeweils fixen Annahmen. Als Ergebnis errechnet sich 50.000 € Rohgewinn. Wir erhalten so aber keine Information über das Risiko und über die Verteilung des Ergebnisses, wenn die Annahmen schwanken. Um alternative Ergebnisse zu ermitteln könnten wir jetzt nacheinander unterschiedliche Werte für die fünf Planungsparameter in das Excel-Sheet eingeben und schauen, wie sich das Ergebnis entwickelt. Aber bereits in diesem ganz einfachen Beispiel wird es mühsam, wenn wir mehr als drei oder vier Variationen berechnen. Bei umfangreichen Businessplänen scheitert dies gänzlich.

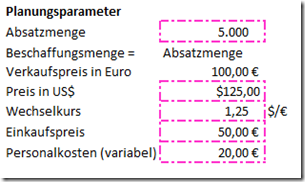

Kommen wir nun zur Planungssimulation. Ausgangspunkt für die Simulation ist der gleiche Plan.[1]

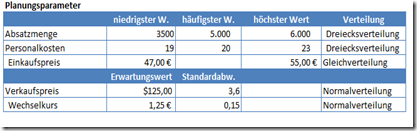

Nun überlegt man, wie die wichtigsten Planungsparameter (= Werttreiber oder Stellhebel) schwanken können. Das ist im Grunde nicht komplizierter als in der traditionellen Planung, in der man ja festzulegen hat, mit welchen Werten man arbeiten will. Bei diesen Festlegungen wird meist über Schwankungen nachgedacht. Bei Simulationsverfahren werden diese Schwankungen nun explizit berücksichtigt.

Die Werttreiber in diesem Beispiel sind Absatzmenge, Verkaufspreis in US$, der Wechselkurs, die variablen Personalkosten und der Einkaufspreis.

Nun kann man, muss es aber nicht, hier über bestimmte Verteilungsformen nachdenken, wie etwa eine Dreiecksverteilung, Normalverteilung oder Gleichverteilung der Werte. Was man hier wählt, hängt letztlich ab vom Prognoseverfahren und den verschiedenen Schätzmethoden[2], über die man ohnehin nachdenken sollte, wenn valide plant. Für dieses Anwendungsbeispiel habe ich folgende Planungsparameter „ermittelt“.

Moderne Tools erlauben über die Nutzung eines Wizards die schwankenden Parameter leicht zu erfassen und zu dokumentieren. Sind die Werte erfasst, kann mit der Simulation begonnen werden. Da dies mit der Generierung von „Zufällen“ geschieht, wird dies auch als Monte-Carlo-Simulation bezeichnet[3].

Mit der Monte-Carlo-Simulation lassen sich also zigtausende künftige Szenarien it-gestützt simulieren[4]. Das charmante an dem Prozess ist, dass man sich auf die Werttreiber und Inhalte konzentrieren kann und die Berechnung vom Programm übernommen wird.

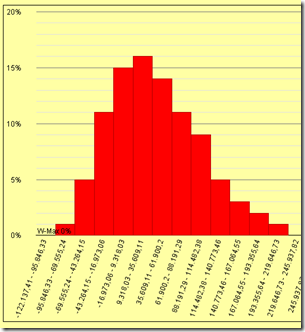

Als Ergebnis erhält man dann z.B. eine Auswertung, die die einzelnen Simulationsergebnisse aggregiert und grafisch und tabellarisch zusammenfasst. Das kann dann etwa so dargestellt werden.

Ergebnisverteilung

So zeigt die folgende Grafik die Verteilung der Ergebnisse an, wenn man die Werttreiber schwanken lässt. Hier erkennt man bereits, dass das in der Punktplanung ermittelte Ergebnis gar nicht das Ergebnis mit der größten Häufigkeit ist.

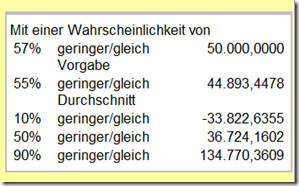

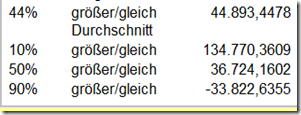

Aussagekräftiger werden die Ergebnisse, wenn man sich die Daten als Wahrscheinlichkeiten anzeigen lässt. Und hier wird es interessant, denn das geplante Ergebnis wird mit einer Wahrscheinlichkeit von 57% 50.000 € erreichen oder niedriger sein.

Der einfache Mittelwert beträgt hier 44.893 € was den Planer vordergründig beruhigen könnte, weil dieser Mittelwert nicht weit vom Zielwert 50.000 € entfernt liegt. Freilich beträgt die Standardabweichung 67.211, und das ist ein sehr hoher Wert, der ein großes Risiko dieser Planung signalisiert[5]. In dem von uns verwendeten Tool kann man nun noch Risikobegrenzungen einbauen, etwa durch Devisenkursabsicherungen, das würde aber jetzt die Komplexität des Beitrags sprengen.

Simulationsrechnungen zeigen z.B. mit welcher Häufigkeit etwa ein Verlust oder ein Liquiditätsengpass auf Basis der Planung droht. So kann sich ein Unternehmen je nach Risikoneigung entsprechend vorbereiten oder bewusst dieses Risiko in Kauf nehmen.

Als ich kürzlich mit dem Finanzchef eines großen mittelständischen exportorientierten Unternehmens sprach, sagte er mir, da werden ja Risiken deutlich, die man vielleicht seinen Kapitalgebern besser nicht zeigt. Meine Antwort darauf ist, ob und wem man sie zeigt, muss der Finanzchef oder der CEO selbst entscheiden.Wichtig ist vor allem, dass man zunächst einmal selbst eine deutlich verbesserte Informationsgrundlage für seine Risiken hat. Simulationen bilden die Komplexität der heutigen Realität von Investitionen, Kapitalanlagen und Projekten deutlich nämlich deutlich besser ab, als einfache Punktplanungen. Dazu kommt, dass allein die Auseinandersetzung damit und die Berücksichtigung im Planungsmodell eine sehr viel validere Darstellungen erlauben.

Den Einwand, solche Simulationen kosten mehr Zeit als herkömmliche Best- und Worst-Case-Planungen, kann ich aus der Praxis nicht bestätigen. Nach unseren Erfahrungswerten verzeichnet man sogar etwa 30% Zeitersparnis gegenüber einer herkömmlichen Best- und Worst-Case-Planung, weil nur eine Spreadsheetdatei mit einer Planung als Analysegrundlage dient[6].

Klar ist freilich, die Qualität einer Simulation steht und fällt mir dem zu Grunde liegendem Planungsmodell. Ist dies Modell zu grob, bildet es Abhängigkeiten nicht oder nur unzureichend ab oder ist es fehlerhaft, dann wird man auch mit einer Simulation diese Mängel nicht ausmerzen können. Auch hier gilt “Garbage in, Garbage out.“

Toolgestützten Reports dokumentieren auch gegenüber externen Kapitalgebern, wie Banken oder Investoren und anderen Stakeholdern ein modernes Planungsverständnis und kann so helfen, die Kapitalkosten zu senken.

Dieser Beitrag ist urheberrechtlich geschützt und in einer ähnlichen Fassung auf der Webseite der CFOWorld erschienen unter dem Titel: Risiken simulieren statt erahnen – Teil 2

Anmerkungen

[1] Dabei sollten bereits im traditionellen Plan die Abhängigkeiten im Kalkulationsblatt richtig miteinander verknüpft sein.

[2] Siehe für Prognose und Schätzverfahren beispielhaft

· Aufwandsschätzung – Überblick über Methoden und Verfahren,

· Kompaktskript zur Vorlesung Prognoseverfahren (pdf)

· Die Aggregation von Risiken im Kontext der Unternehmensplanung (pdf)

[3] Das Vorgehen erklärt Werner Gleißner in einem Fachaufsatz sehr verständlich:

1. Erzeugen der für die Monte-Carlo-Simulation benötigten Zufallszahlen.

2. Umwandeln der Zufallszahlen in die benötigte Verteilung

3. Berechnen eines Szenarios einer Monte-Carlo-Simulation gemäß den gezogenen Zufallszahlen und der zugehörigen Verteilung.

4. Wiederholen der Schritte 1, 2 und 3, bis eine ausreichende Anzahl von Simulationen generiert wurde, die eine Ableitung stabiler Verteilungen und statistischer Kennzahlen erlaubt.

5. Berechnen von Mittelwert, Standardabweichung oder Quantilen etc. bzw. des Value at Risk der insgesamt simulierten Szenarien

[4] Die Monte-Carlo-Simulation lässt sich auch als ein Stichprobenverfahren interpretieren, da die Inputwerte zufällig gemäß einer Wahrscheinlichkeitsverteilung generiert werden, die die Stichprobenerhebung einer wirklichen Population simuliert. Vgl. Heinrich Rommelfanger, Stand der Wissenschaft bei der Aggregation von Risiken in: Risikoaggregation in der Praxis, Heidelberg 2007, S. 41.

[5] Zu großen Schwankungen führen hier übrigens Wechselkursveränderungen.

[6] Das charmante an dem Verfahren ist, dass mit einem entsprechenden Tool die zentrale Planungsdatei gar nicht verändert werden braucht, wenn mit Bezugsgrößen und Abhängigkeiten gearbeitet wird. Die Tools rechnen auf Basis der Werte und Formeln in der bisher eingesetzten Tabellen, verwenden aber für die simulierenden Werte die im Tool eingegebenen Vorgaben.

Literaturübersicht Teil 2

Wer das Thema vertiefen und auch die Grundlagen erarbeiten möchte, für den habe ich hier weitere Literaturhinweise.

Dana Mietzner/Guido Reger, Advantages and disadvantages of scenario approaches for strategic foresight, in: Int. J. Technology Intelligence and Planning, Vol. 1, No. 2, 2005, Working papers in accounting valuation auditing 2010-5

Heinrich Rommelfanger, Stand der Wissenschaft bei der Aggregation von Risiken in: Risikoaggregation in der Praxis, Heidelberg 2007

Georg Strohmeier, Ganzheitliches Risikomanagement in Industriebetrieben, Wiesbaden 2007

Meine ganz eigene site im internet. Da schreib ich über vielen Dingen die ich sehr spannend finde wenn ich die Möglichkeit habe. Es macht mir Spaß zu philosophieren und ich wäre froh wenn du mal meine Page besuchst!

Comments on this entry are closed.